> ### python爬虫爬取百度百科页面

> 简单爬虫框架:

> 爬虫调度器 -> URL管理器 -> 网页下载器(urllib2) -> 网页解析器(BeautifulSoup) -> 价值数据

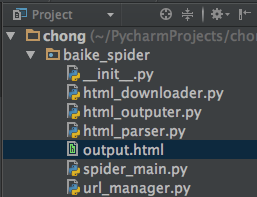

目录结构:

> 注:mac osx下用alt+enter添加相应方法

- (爬虫调度器)spider_main.py

- (url管理器)url_manager.py

- (下载器)html_downloader.py

- (解析器)html_parser.py

- (数据输出)html_outputer.py

> 运行程序spider_main.py可进行爬取页面,最终文件输出为output.html,里面包含词条和词条解释,爬取完毕。

output.html:

通过python爬虫采集城市的酒店数据

内容概要:使用python采集酒店数据

适用人群:做酒店数据市场调研,数据分析报告的人群

使用场景及目标:需要依靠python3环境,执行爬虫脚本

其他说明:需要使用开发者工具捕捉网站中的目标城市对应的cityCode,城市编号,如有侵权,联系删除

2023-02-24 23:31:27

7KB

1

基于Python的Csdn博客爬虫(多线程)

说明

爬取Csdn某个博主的所有博文,并下载到本地(暂时只支持保存html格式),加入了多线程,爬取更快速。

SpiderGui----------------->爬虫gui界面

CsdnBlogSpider------------>爬虫主程序

环境

Python3.4

运行

* 确保安装Python解释器。

* SpiderGui.py

* 提示输入要爬取的博客名和开启线程数,根据自己需求配置

* 开始爬取,存储在当前目录的blog文件夹下

存在问题

本爬虫还不够完善,欢迎大家指导

2023-02-23 14:07:58

3KB

1

主要使用Python中第三方库Scrapy爬虫框架,首先你需要阅读README.md文件说明,然后输入你的微博cookie,然后输入关键词、爬取日期等等信息,最后运行即可。

2023-02-21 17:56:41

6.42MB

1

该资源使用python语言,实现了从连镓网站爬取数据的功能

并将爬取到的数据存储到文件夹,可以利用其进行进一步数据分析、可视化

也可以利用其进行房价预测等任务的数据集

本资源爬取了房源的价格、小区名、楼层、建筑面积、户型结构、套内面积、装修情况等等详细的房源相关描述的数据

如果有相关需求,大家可以使用该项目爬取数据进行数据分析,也可以使用本人已经爬取到的数据直接进行进一步处理

2023-02-21 15:56:31

682KB

1

新浪微博需要登录才能爬取,这里使用m.weibo.cn这个移动端网站即可实现简化操作,用这个访问可以直接得到的微博id。

分析新浪微博的评论获取方式得知,其采用动态加载。所以使用json模块解析json代码

单独编写了字符优化函数,解决微博评论中的嘈杂干扰字符

本函数是用python写网络爬虫的终极目的,所以采用函数化方式编写,方便后期优化和添加各种功能

# -*- coding:gbk -*-

import re

import requests

import json

from lxml import html

#测试微博4054483400791767

comments=[]

def

2023-02-21 11:09:15

47KB

1

(1)用户登录注册。

(2)修改密码。

(3)用户个人中心。

(4)图书展示

(5)图书推荐

(6)图书分类展示

(7)图书收藏

(8)收货地址管理

(8)后台数据管理,包括用户信息管理、图书信息管理、分类信息管理。

使用前请仔细查看说明文档

2023-02-19 20:39:08

94.05MB

1

摘要:随着大数据时代的日益发展,数据的获取与分析成为热点。本文通过利用Python抓取豆瓣TOP250的相关数据,并将数据存储在Excel文件中,借助Python功能完备的标准库、Requests、BeautifulSoup等第三方库编写程序实现豆瓣电影TOP250数据的抓取,后利用Jieba、NumPy等第三方库对所需数据进行数据预处理,再借助PyEcharts等第三方库对已处理好的数据进行数据可视化,最终得到词云图、网页动态图等图表,分别在电影类型、发行时间、导演、发行地区、评分及评价人数方面加以分析理解,从而得出数据之间的相关性、国内人群喜爱的电影类型等相关结论。

2023-02-19 08:55:56

975KB

1