爬取电影天堂最新的电影数据 - xpath

爬取腾讯招聘的职位数据 - xpath

爬取中国天气网全国天气并生成饼状图 - bs4

爬取古诗词网的数据 - re

爬取糗事百科上的段子数据 - re

多线程爬虫

多线程爬取斗图吧的表情图并下载到本地 - xpath + threading

使用 itchat 发送表情到指定的人和微信群

多线程爬取百思不得姐的文字和图片信息并写入到csv中

Selenium 自动化爬虫

爬取拉勾网的职位信息 - selenium + requests + lxml

爬取 Boss 直聘网的职位信息 - selenium + lxml

Scrapy 框架爬虫

爬取糗事百科的段子保存到 JSON 文件中

爬取微信小程序论坛的数据

登录豆瓣网并修改个性签名

下载汽车之家的高清图片到本地

爬取简书网所有文章数据

爬取房天下所有房的数据,包含新房、二手房

feapder

feapder AirSpider实例

Node.js 爬虫

使用 puppeteer 爬取简书文章并保存到本地

其他

使用 Python 定位到女朋友的位置

2023-03-16 18:00:15

3.68MB

1

可以使用python实现基本的图片爬取和保存功能,用户可以根据自己需求自定义要爬取的链接,但是相应的也要根据网页结果更改部分代码,代码清晰,思路明确,适合学习python爬虫爬取图片参考。

2023-03-08 22:06:44

1KB

1

本程序可以连续爬取一个或多个新浪微博用户(如胡歌、迪丽热巴、郭碧婷)的数据,并将结果信息写入文件或数据库。写入信息几乎包括用户微博的所有数据,包括用户信息和微博信息两大类。因为内容太多,这里不再赘述,详细内容见获取到的字段。如果只需要用户信息,可以通过设置实现只爬取微博用户信息的功能。本程序需设置cookie来获取微博访问权限,后面会讲解如何获取cookie。如果不想设置cookie,可以使用免cookie版,二者功能类似。

爬取结果可写入文件和数据库,具体的写入文件类型如下:

txt文件(默认)

csv文件(默认)

json文件(可选)

MySQL数据库(可选)

MongoDB数据库(可选)

SQLite数据库(可选)

同时支持下载微博中的图片和视频,具体的可下载文件如下:

原创微博中的原始图片(可选)

转发微博中的原始图片(可选)

原创微博中的视频(可选)

转发微博中的视频(可选)

原创微博Live Photo中的视频(免cookie版特有)

转发微博Live Photo中的视频(免cookie版特有)

2023-03-04 11:00:59

111KB

1

一个基于Python爬虫的有道翻译接口

用法

a=Search_words() #初始化对象

b=a.Simple_search(“Hello”) #进行搜索,支持中译英/英译中,返回一个字典

字典内数据

返回的数据可能含有换行符或、标记以及空格,请自行过滤

b['Word']

查询的单词

b['pronounce']

音标 b["pronounce"][0]为英式

b["pronounce"][1]为美式(部分有)

b['Simple-meaning']

释义(英译中)

d['Internet-meaning']

网络释义

b['Phrase']

相关短语

b['Sentence']

相关句子

b['Chinese-meaning']

释义(中译英)

b['Guess']

猜你想搜(大部分情况为空,反之有可能输入了错误的单词)

b['Pin-Yin']

拼音

示例

if __name__ == '__main__':

a=Search_words()

print

2023-03-03 18:26:06

6KB

1

互联网成了海量信息的载体,目前是分析市场趋势、监视竞争对手或者获取销售线索的最佳场所,数据采集以及分析能力已成为驱动业务决策的关键技能。《计算机行业岗位招聘数据分析》旨在利用python编写爬虫程序,从招聘网站上爬取数据,将数据存入到Mysql数据库中,将存入的数据作一定的数据清洗后做数据分析,最后将分析的结果做数据可视化。

爬取招聘网站(智联招聘)上的计算机行业数据,字段为公司招聘链接,公司名称,公司规模,公司性质,职位领域,职位名称,学历要求,职位类别,职位亮点(福利),工资水平,城市,工作经验,简历统计,公司打分,工作地址,职位要求,人员需求,公司业务范围,进行数据清洗及数据维度分析进行数据可视化。

此项目完成之后将大大节约我们查找招聘岗位的时间,它的重大意义是让我们查看工作岗位信息数据进行了数据化、规范化、自动化、可视化管理。它可以帮助我们了解行业的薪资分布、城市岗位分布、岗位要求关键字、岗位经验要求等等一系列的数据。

2023-03-01 11:36:23

3.43MB

1

基于scrapy编写的爬虫,能够爬取城市二手房的各种信息,比如房价、面积、所处位置等十分方便易用,并采用Beautifulsoup进行页面解析无视反爬机制

2023-02-28 16:48:02

195KB

1

基于weibo.com的新版API构建,拥有最丰富的字段信息

多种采集模式,包含微博用户,推文,粉丝,关注,转发,评论,关键词搜索

支持针对单个关键词获取单天超过1200页的检索结果 #257

支持长微博全文的获取

基于关键词微博搜索支持指定时间范围

添加IP归属地信息的采集,包括用户数据,微博数据和微博评论数据

该项目需要安装Python环境和MongoDB数据库,可以直接使用

2023-02-27 19:23:06

17KB

1

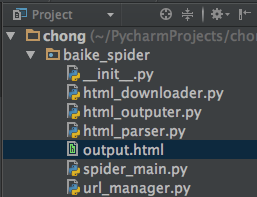

> ### python爬虫爬取百度百科页面

> 简单爬虫框架:

> 爬虫调度器 -> URL管理器 -> 网页下载器(urllib2) -> 网页解析器(BeautifulSoup) -> 价值数据

目录结构:

> 注:mac osx下用alt+enter添加相应方法

- (爬虫调度器)spider_main.py

- (url管理器)url_manager.py

- (下载器)html_downloader.py

- (解析器)html_parser.py

- (数据输出)html_outputer.py

> 运行程序spider_main.py可进行爬取页面,最终文件输出为output.html,里面包含词条和词条解释,爬取完毕。

output.html:

通过python爬虫采集城市的酒店数据

内容概要:使用python采集酒店数据

适用人群:做酒店数据市场调研,数据分析报告的人群

使用场景及目标:需要依靠python3环境,执行爬虫脚本

其他说明:需要使用开发者工具捕捉网站中的目标城市对应的cityCode,城市编号,如有侵权,联系删除

2023-02-24 23:31:27

7KB

1