农业领域知识图谱的构建,包括数据爬取(百度百科)、数据分类、利用结构化数据生成三元组、非结构化数据的分句(LTP),分词(jieba),命名实体识别(LTP)、基于依存句法分析(主谓关系等)的关系抽取和利用neo4j生成可视化知识图谱

2025-11-19 21:13:53

21.4MB

1

在当今互联网信息爆炸的时代,网络爬虫技术作为获取网络数据的一种重要手段,被广泛应用于搜索引擎、数据分析、内容聚合等多个领域。百度百科作为中文网络信息的重要来源之一,拥有大量的词条数据,是研究网络爬虫技术的理想目标。基于Python的百度百科爬虫_hy5.zip文件,旨在利用Python编程语言,设计并实现一个高效的网络爬虫程序,以此来爬取百度百科上的词条信息。

Python语言因其简洁明了的语法和强大的网络编程库支持,在编写网络爬虫时具有得天独厚的优势。Python的requests库能够方便地发起网络请求,而BeautifulSoup和lxml等库可以轻松解析HTML页面,进一步提取所需的数据。此外,Python的Scrapy框架为复杂爬虫项目的开发提供了更为高效和系统的解决方案。

爬虫技术的核心在于模拟浏览器访问网页,提取页面中的有用信息。对于百度百科而言,需要爬虫程序能够处理百度百科页面的分页、跳转、异步加载等多种动态加载内容的情况。同时,对于词条数据的提取,需要精确地定位到每个词条的具体信息部分,如词条名、简介、分类、相关链接等。

在编写爬虫程序时,还需要考虑到反爬虫机制的应对策略。百度百科作为百度的重要产品,自然有其严格的反爬虫策略,例如通过检测用户请求的频率、验证用户代理(User-Agent)、动态生成的验证码等方式来阻止爬虫的访问。因此,爬虫程序需要能够模拟正常用户的浏览行为,合理设置请求间隔,甚至可能需要处理验证码等安全验证。

一旦爬虫程序能够有效运行,它将能够收集到大量的词条数据。这些数据可以用于各种数据挖掘和分析工作,比如通过词频分析来了解社会热点话题,通过分类统计来构建知识图谱等。此外,百度百科爬虫的开发不仅仅是一个技术实现的过程,它还涉及到相关的法律法规遵循。在进行网络爬取时,必须遵守《中华人民共和国网络安全法》等相关法律法规,尊重数据的版权和隐私权,不得进行非法的爬取和使用。

百度百科爬虫项目在实际应用中也具备一定的价值。比如,对于搜索引擎来说,可以利用爬虫技术定期更新词条数据,保证搜索结果的时效性和准确性。对于研究机构,可以用来研究中文词条的演变过程和语言习惯的变迁。对于教育机构,可以作为教学资源,帮助学生更好地理解和掌握知识。

基于Python的百度百科爬虫_hy5.zip文件代表了一项能够解决实际问题的技术实践,它不仅展示了Python在网络爬虫领域的应用潜力,也体现了面对复杂网络环境下的数据提取和处理能力。通过对百度百科词条数据的爬取和分析,可以为用户提供丰富多样的信息来源,为数据研究提供有力支持。

2025-07-10 14:40:42

18KB

1

Python爬虫技术是数据获取和网络自动化的重要工具,尤其在大数据时代,对于网站信息的抓取和分析具有显著价值。本教程将详细讲解如何利用Python爬虫技术来爬取百度百科上的信息。百度百科作为中文互联网上最大的在线百科全书之一,提供了丰富的知识资源,学习如何爬取其数据,对数据挖掘、信息分析等领域大有裨益。

我们需要了解Python爬虫的基本概念。Python爬虫是通过编写程序模拟浏览器发送HTTP请求(GET或POST)到目标服务器,接收服务器返回的HTML或JSON等格式的数据,然后解析这些数据以获取所需信息。Python中常用的爬虫库包括requests用于发送HTTP请求,BeautifulSoup或者lxml用于解析HTML文档。

在爬取百度百科时,我们需要首先分析网页结构。通常,使用浏览器的开发者工具查看网页源代码,找出目标信息所在的HTML标签。例如,百度百科的条目内容可能包含在特定的div标签中,我们可以定位到这些标签,提取出我们需要的数据。

接着,我们将编写Python代码。使用requests库发送GET请求到百度百科的URL,例如搜索“Python”得到的页面。请求成功后,接收到的响应内容可以使用BeautifulSoup解析。以下是一个简单的示例:

```python

import requests

from bs4 import BeautifulSoup

# 发送GET请求

url = 'https://baike.baidu.com/item/Python'

response = requests.get(url)

# 解析HTML

soup = BeautifulSoup(response.text, 'html.parser')

# 找到目标元素,例如文章内容

content_div = soup.find('div', {'class': 'lemmaWgt-lemmaContent'})

# 提取并处理数据

content = content_div.get_text()

```

在实际爬虫项目中,我们还需要处理一些常见问题,如登录验证、反爬虫策略、动态加载内容等。对于登录验证,可能需要使用requests的session对象或模拟cookie;对于反爬策略,可以设置User-Agent,延时请求,甚至使用代理IP;对于动态加载内容,可能需要借助Selenium等工具。

百度百科可能会对频繁的爬虫行为进行限制,因此在编写爬虫时,要遵循网站的robots.txt规则,并合理控制请求频率,尊重网站的权益。

此外,考虑到百度百科的数据量较大,如果需要爬取大量条目,可以采用多线程或异步IO来提高爬取效率。Python的threading或asyncio库能帮助实现这一目标。

爬取到的数据可以存储为文本文件、CSV或数据库等形式,便于后续分析和使用。例如,我们可以将每条百科条目的标题和内容写入CSV文件:

```python

import csv

with open('baidu_baike.csv', 'w', newline='', encoding='utf-8') as csvfile:

fieldnames = ['title', 'content']

writer = csv.DictWriter(csvfile, fieldnames=fieldnames)

writer.writeheader()

for item in items: # 假设items是从爬取结果中提取的条目列表

writer.writerow({'title': item['title'], 'content': item['content']})

```

Python爬虫爬取百度百科涉及的知识点包括:HTTP协议与requests库的使用、HTML解析(BeautifulSoup或lxml)、网页结构分析、爬虫策略与反反爬、数据存储等。通过这个过程,你可以深入了解Web爬虫的工作原理,并提升数据获取的能力。

2025-07-08 22:57:27

9KB

1

格式:词条 + 标记符号 +解释,没有解释证明百科中没有该词条

2024-03-03 15:51:22

2.38MB

1

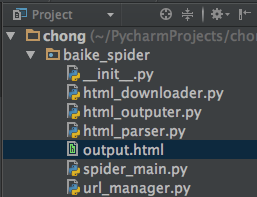

> ### python爬虫爬取百度百科页面

> 简单爬虫框架:

> 爬虫调度器 -> URL管理器 -> 网页下载器(urllib2) -> 网页解析器(BeautifulSoup) -> 价值数据

目录结构:

> 注:mac osx下用alt+enter添加相应方法

- (爬虫调度器)spider_main.py

- (url管理器)url_manager.py

- (下载器)html_downloader.py

- (解析器)html_parser.py

- (数据输出)html_outputer.py

> 运行程序spider_main.py可进行爬取页面,最终文件输出为output.html,里面包含词条和词条解释,爬取完毕。

output.html:

本文实例讲述了Python爬虫实现爬取百度百科词条功能。分享给大家供大家参考,具体如下:

爬虫是一个自动提取网页的程序,它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。爬虫的工作流程较为复杂,需要根据一定的网页分析算法过滤与主题无关的链接,保留有用的链接并将其放入等待抓取的URL队列。然后,它将根据一定的搜索策略从队列中选择下一步要抓取的网页URL,并重复上述过程,直到达到系统的某一条件时停止。另外,所有被爬虫抓取的网页将会被系统存贮,进行

2022-11-15 20:43:26

368KB

1

前言

关于python版本,我一开始看很多资料说python2比较好,因为很多库还不支持3,但是使用到现在为止觉得还是pythin3比较好用,因为编码什么的问题,觉得2还是没有3方便。而且在网上找到的2中的一些资料稍微改一下也还是可以用。

好了,开始说爬百度百科的事。

这里设定的需求是爬取北京地区n个景点的全部信息,n个景点的名称是在文件中给出的。没有用到api,只是单纯的爬网页信息。

1、根据关键字获取url

由于只需要爬取信息,而且不涉及交互,可以使用简单的方法而不需要模拟浏览器。

可以直接

http://baike.baidu.com/search/word?word

2022-08-22 16:36:24

77KB

1